Otpočela je još jedna trka za predsednika Amerike, ovog puta borba je prljavija nego ikad. Realistični, ali lažni video snimci Klintonove i Bajdena, koje su stvorili algoritmi veštačke inteligencije na osnovu velikog broja stvarnih snimaka, među hiljadama su onih koji se pojavljuju na društvenim mrežama i zamenjuju činjenice u podeljenoj američkoj politici.

„Zapravo mi se jako dopada Ron Desantis“, otkriva Hilari Klinton u snimku koji niko nije očekivao. „On je prava osoba koja treba ovoj zemlji, zaista tako i mislim“.

Džou Bajdenu konačno pada maska i počinje da urla na transrodnu osobu:“Nikada nećeš biti prava žena“, prenosi Glas Aamerike, konkretne izjave predsedničkih kandidata, koje nikada nisu izgovorili.

Glasači neće moći da razlikuju realnost od laži

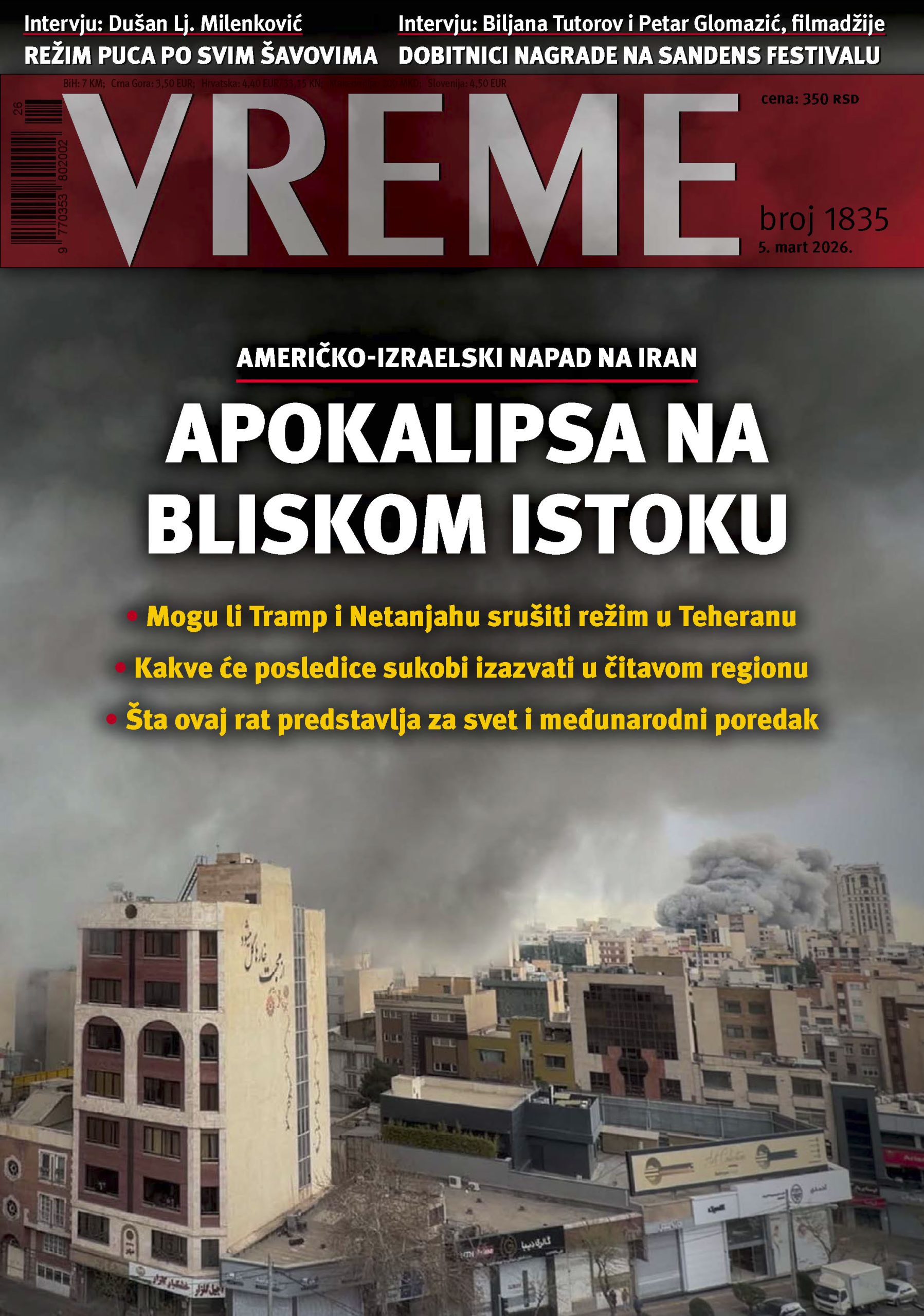

Takvi sintetički snimci kruže već nekoliko godina, a tokom prošle godine su postali sve ćešči. Alati za kreiranje AI (veštačke inteligencije), kao što je „Midjourney“ postali su jeftiniji i dostupniji za pravljenje ubedljivih “dipfejkova”, što pokazuje serija intervjua koju je Rojters imao sa preko dvadeset stručnjaka za AI, dezinformacije na internetu i politički aktivizam.

„Biće jako teško da glasači razlikuju realnost od laži, možete samo da zamislite kako će sve oni koji podržavaju Trampa ili Bajdena moći da koriste ove tehnologije da bi učinili da protivnik izgleda loše“, kaže Darel Vest, viši saradnik Centra za tehnološke inovacije Brukings instituta.

Prema „DeepMedia“ kompaniji koja radi na načinima da se otkrije sintetički medijski sadržaj, bilo je trostruko više dipfejk video snimaka svih vrsta i osam puta više dipfejk tonskih snimaka na internetu ove godine, u poređenju sa istim periodom prošle godine.

Očekuje se pola miliona lažnih video snimaka na društvenim mrežama

Sve zajedno, oko pola miliona video i audio dipfejkova će biti objavljeno na društvenim mrežama u svetu ove godine, procenjuje ta kompanija.

Nekada je kloniranje glasa koštalo 10.000 dolara na serveru, ali sada startap kompanije nude učenje veština za AI za nekoliko dolara, navodi kompanija.

Niko ne može sa sigurnošću da kaže kuda vodi AI put ili kako bi bila efikasna zaštita od njegove moći da širi dezinformacije, naveli su Rojtersovi sagovornici.

Obmane glasača sve kreativnije

Eksperti iz oblasti veštačke inteligencije (AI) sve češće otkrivaju alarmantne scenarije u kojima se generativna AI koristi za stvaranje lažnih slika, video i audio zapisa, u svrhu zbunjivanja glasača, klevetanja kandidata ili čak podsticanja nasilja.

Automatizovani pozivi sa glasom kandidata, koje upućuju glasače da glasaju pogrešnog datuma; audio snimci kandidata koji navodno priznaju zločin ili izražavaju rasističke stavove; video snimak koji prikazuje nekoga kako drži govor ili intervju koji nikada nije održao. Lažne slike dizajnirane da izgledaju kao lokalni izveštaji, tvrdeći da je kandidat odustao od trke.

Pokušaj regulacije

Neke države već predlažu zakone koji bi od kandidata zahtevali da označavaju reklame za kampanju kreirane pomoću veštačke inteligencije. Da sve može otići predaleko, ukazuje i strah pojedinih američkih političara da bi generativna veštačka inteligencija mogla da se koristi pre izbora 2024. za kreiranje video ili audio snimka koji pozivaju na nasilje nad pojedinicima.

Z.S./Glas Amerike/Benchmark

Čitajte dnevne vesti, analize, komentare i intervjue na www.vreme.com